Manipulación de la información

¿Qué es la manipulación de la información?

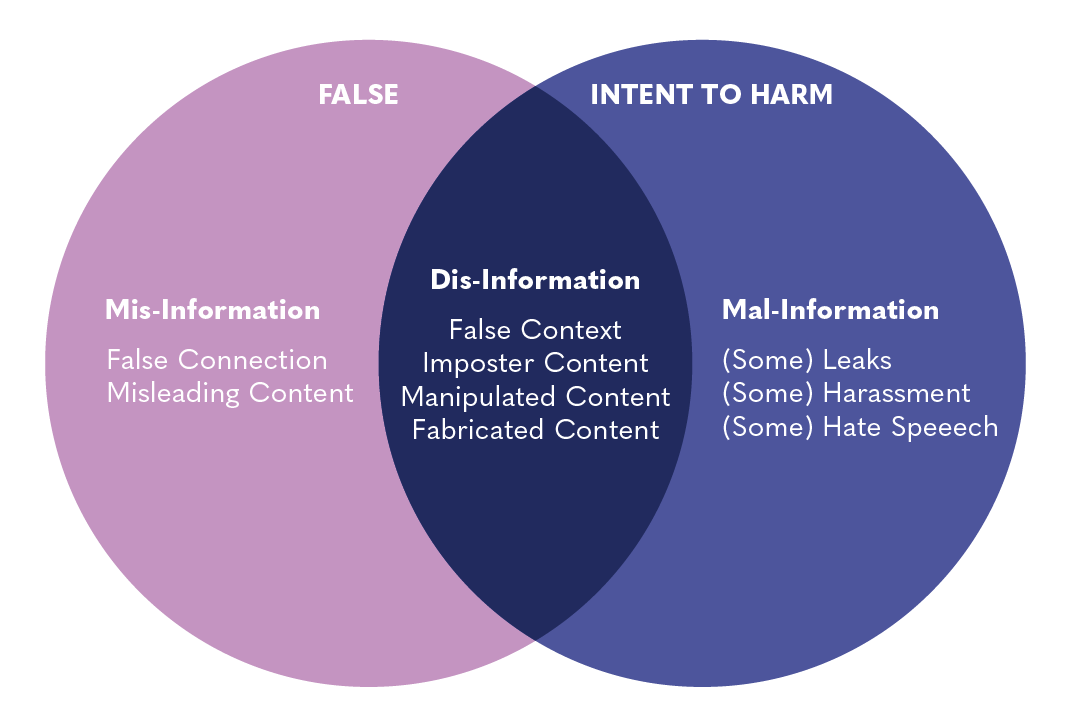

La manipulación de la información comprende una serie de tácticas que involucran la recolección y difusión de información para influir o perturbar la toma de decisiones democrática. Muchos tipos de contenidos distintos pueden estar involucrados en ella, como la manipulación de la información, la desinformación, la misinformación y la mal-información, la propaganda y los discursos de odio. Estos contenidos pueden usarse para influir en las actitudes o creencias del público, persuadiendo a las personas de que actúen o se comporten de determinado modo —como suprimir el voto de un grupo particular de personas— o incitando al odio y la violencia. Una diversidad de actores puede participar en la manipulación de la información, desde gobiernos domésticos, partidos políticos y campañas, a actores comerciales, gobiernos extranjeros y grupos extremistas. La manipulación de la información puede cooptar los canales de información tradicionales, como las transmisiones televisivas, la imprenta y la radio, así como los medios sociales.

Desinformación

La desinformación es información falsa o engañosa, difundida con la intención de engañar o causar daño. Siempre tiene un propósito y no necesariamente está conformada por mentiras o falsificaciones abiertas. La inclusión de ciertos hechos verdaderos o “verdades a medias” privadas de contexto, puede hacer que la desinformación sea más creíble y más difícil de reconocer.

Desinformación = información falsa + intención de causar dañom

Misinformación

La misinformación es el compartir inadvertidamente información falsa o errada. Difiere de la desinformación debido a la ausencia de una intención de engañar o causar daño, y la persona que la comparte por lo general cree que es verdad. Un ejemplo de misinformación son los rumores que se propagaron en los medios sociales durante la pandemia de COVID-19 acerca de “curas” que no tenían base alguna en la ciencia médica.

Misinformación = información falsa + error

Claire Wardle & Hossein Derakhshan, 2017

Mal-información

La mal-información es información verdadera sin el debido contexto en un intento de engañar, confundir o causar daño.

Mal-información = información verdadera + intención de causar daño

Discursos de odio[2]

Los discursos de odio son el uso de un lenguaje discriminador con respecto a una persona o grupo sobre la base de su identidad, lo que incluye su religión, etnicidad, nacionalidad, habilidad, género u orientación sexual. A menudo forman parte de un esfuerzo de manipulación más amplio.

Propaganda[3]

La propaganda es información diseñada para promover un objetivo, acto o resultado político. A menudo involucra la desinformación, pero también puede usar hechos, información robada o medias verdades para convencer a las personas. Frecuentemente hace llamados emocionales en lugar de concentrarse en pensamientos o argumentos racionales. La propaganda está usualmente asociada con actores afiliados al Estado, pero también puede ser propagada por otros grupos y personas.

Términos afines[4]

Discurso peligroso

Según el Dangerous Speech Project, el “discurso peligroso” es toda forma de expresión (habla, texto o imágenes) que puede incrementar el riesgo de que su público apruebe o participe en la violencia cometida contra miembros de otro grupo”. Este concepto brinda un marco constructivo con que reflexionar acerca de los discursos de odio que es probable provoquen violencia. Las señales de un discurso peligroso incluyen la deshumanización (referirse a la gente como insectos, bacterias, etc.) y decirles que enfrentan una amenaza mortal proveniente de un grupo minoritario desfavorecido.

el término “fake news” (noticias falsas) no cuenta con una definición aceptada y es empleado erróneamente como un sinónimo de desinformación. Se ha popularizado en los últimos años y a menudo se le usa para desacreditar la información que uno encuentra desfavorable independientemente de su veracidad. Así, los términos “misinformación”, “desinformación” o “mal-información” debieran usarse en lugar de “fake news”.

Astroturfing: el intento de dar la impresión de un difundido apoyo o interés de base a una política o idea usando cuentas falsas en línea, como redes de bots o grupos de presión falsos.

Bots: un bot es un programa de software que efectúa tareas automatizadas y repetitivas. En el caso de los medios sociales, un bot podría referirse a una cuenta automatizada en dichos medios.

Click Bait: el título sensacionalista o engañoso de un artículo, enlace o thumbnail (miniatura), diseñado para hacer que los usuarios vean el contenido.

Ciberviolencia y ciberbullying: la ciberviolencia se refiere a actos de abuso usando medios digitales. El ciberbullying se refiere a la ciberviolencia que es recurrente y que está caracterizada por una dinámica de poder desbalanceada.

Deepfake: fotografías o videos que han sido alterados o fabricados íntegramente mediante aprendizaje automático para crear una falsa representación de algo, como un político que hace una declaración imaginada. El uso de deepfakes para confundir a los votantes durante los periodos electorales fabricando declaraciones de los candidatos y funcionarios electorales, es un excelente ejemplo de manipulación de la información.

Doxxing: la publicación de información privada o identificadora de una persona en línea con intención maliciosa, en especial la información personal sensible.

Information Warfare: el uso de las TIC como los medios sociales para influir o debilitar a un contrincante, lo que incluye el uso de la desinformación y la propaganda.

Trolling: la creación intencional de discordia en un espacio de discusión en línea comenzando peleas entre los usuarios, o molestando en general a la gente publicando mensajes inflamatorios, insultando o dando mensajes fuera de tema.

Filtros de subir archivos: programas de computadora automatizados que escanean los contenidos subidos a una plataforma en línea antes de que sean publicados. Estos filtros los usan las plataformas de medios sociales para identificar contenidos que violan los términos de servicio de las compañías, como materiales de abuso sexual infantil (CSAM).

Contenidos generados por usuarios (UGC): todo contenido como imágenes, videos, textos y audios que han sido publicados por los usuarios en plataformas en línea.

Viralidad: la tendencia de una imagen, video o nota de información a circular rápida y ampliamente en las plataformas en línea. Cuando el contenido se hace “viral” a menudo se pierde el importante contexto que rodea a la información como su fuente, autor y fecha de publicación (lo que se conoce como “colapso del contexto”), distorsionando potencialmente la forma en que la información es recibida e interpretada por quienes la ven.

Para definiciones adicionales véase el glosario de desinformación, del Disinfo Lab de la UE, que es una colección de 150+ términos con que entender el desorden de la información.

¿De qué modos la manipulación de la información trastorna y distorsiona el ecosistema de la información?

La manipulación de la información no es una amenaza nueva, pero se ha ampliado en la era digital. Las plataformas de medios sociales y los algoritmos que las sustentan facilitan la propagación de la información —lo que incluye información falsa— a velocidades sin precedentes. A medida que los ciudadanos del mundo pasan a depender de los medios sociales para la comunicación personal, el consumo de noticias y en general desarrollar una comprensión cotidiana de qué está sucediendo en el mundo, se van haciendo cada vez más vulnerables a la manipulación de información en dichas plataformas.

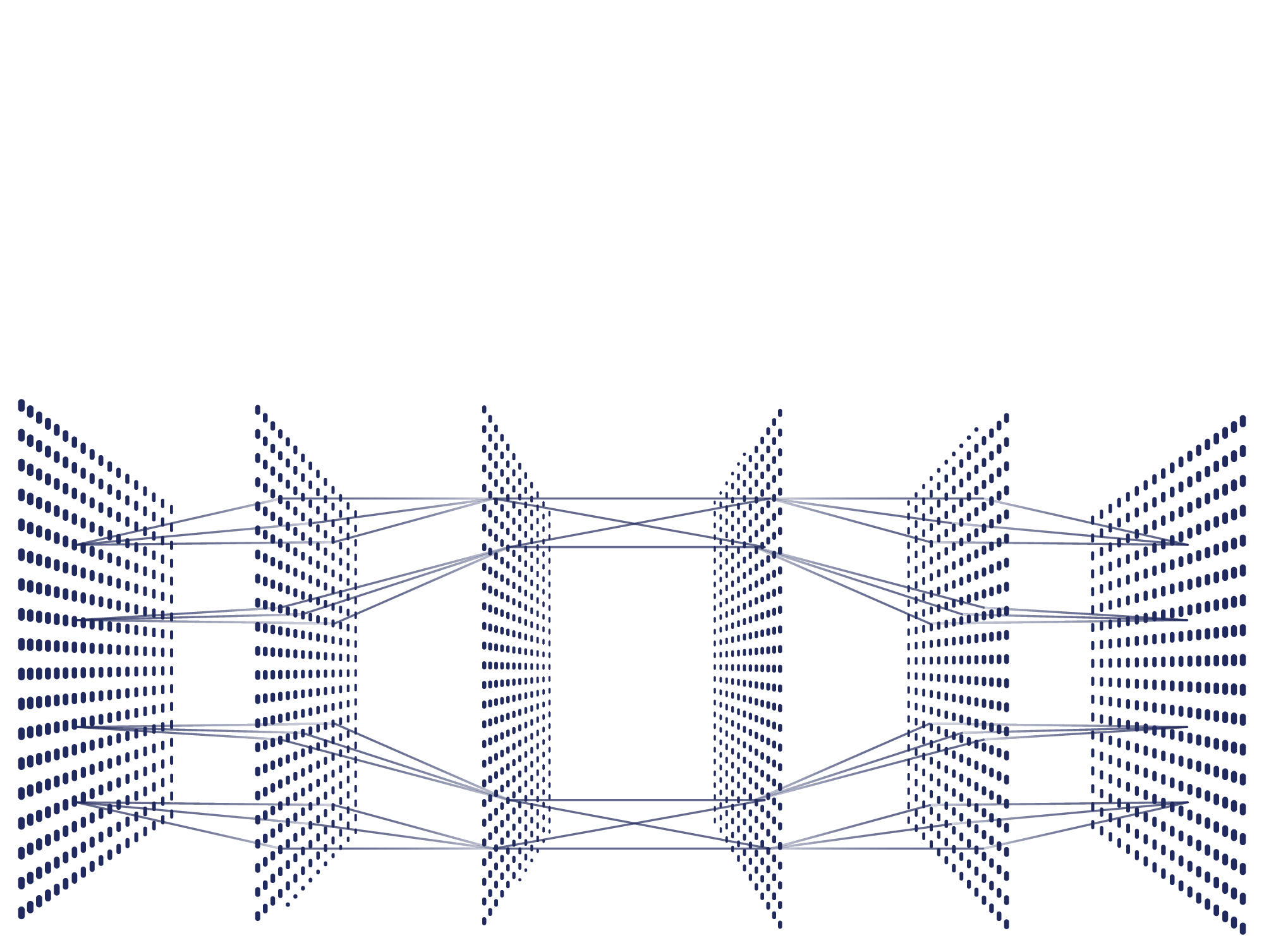

Aunque las plataformas de medios sociales populares como Facebook, X (antes Twitter) y YouTube son criticadas a menudo por su papel en facilitar la manipulación de la información, este problema frecuentemente también prevalece en otras plataformas como Instagram, TikTok, Reddit y hasta Pinterest. La manipulación de la información es también común en apps de mensajería encriptadas y no encriptadas como LINE, Telegram, WhatsApp, Facebook Messenger, Signal, WeChat y Viber. El surgimiento de diversos actores comerciales que ofrecen desinformación como servicio hace que para las compañías de medios sociales sea más duro detectar y tomar acción contra la manipulación de la información, como trols contratados a los que se paga para contaminar la esfera de la información. La distinción entre cuentas automatizadas de bots y los contenidos curados por humanos está asimismo haciéndose menos clara, y algunos estudios sugieren que menos del 60% del tráfico global en la web es humano. Consúltese el recurso sobre los medios sociales para mayor información acerca de cómo es que el modelo de ingresos de muchas plataformas de medios sociales podría desincentivar aún más la eliminación proactiva de la misinformación y la desinformación y el comportamiento no auténtico.

Las investigaciones han mostrado que los contenidos falsos y desorientadores tienden a llegar a los públicos en línea con mayor rapidez que la información basada en hechos sobre el mismo tema. Un estudio sobre la propagación de falsedades, por ejemplo en X, halló que una noticia falsa tendía a alcanzar un público de 1,500 personas seis veces más rapido que una precisa. ¿Por qué? Tras las evaluaciones iniciales de la desinformación que se concentraban en su oferta —lo que incluye la forma en que la internet y los medios sociales han incrementado el alcance, la velocidad y la magnitud de la desinformación—, los investigadores dirigieron su atención a la demanda de desinformación. Se encontró que la psicología humana tiene un papel en el consumo de información que refuerza los puntos de vista y sesgos existentes, evoca una fuerte respuesta emociona, y/o demoniza a los ‘exogrupos. Las plataformas digitales que jerarquizan y recomiendan contenidos para optimizar el compromiso y el tiempo pasados en las plataformas crean “bucles de retroalimentación degenerados,” que amplifican y agravan estas tendencias.

Las innovaciones en inteligencia artificial generativa, lo que incluye el lanzamiento de ChatGPT y de chatbots avanzados similares a finales de 2022, introdujeron oportunidades adicionales para la manipulación de la información al hacer que la desinformación sea más barata y fácil de producir para un número aún más grande de teóricos de la conspiración y actores malignos. Estos riesgos más grandes se deben en parte a la capacidad de las herramientas de IA generativa para “adaptar el lenguaje para que calce con ciertos contextos y localice formas de hablar”, así como para “multiplicar las falsas narrativas con el mismo mensaje redactado de múltiples formas, lo que podría elevar la cantidad de falsos contenidos [en línea] y hacer que sea difícil medir su viralidad”. La IA generativa puede también usarse para hacer que las cuentas automatizadas de bots suenen más humanas, y para crear fotos de perfil falsas y que hagan que otras formas de medios sintéticos como los “deepfakes” se vean aún más realistas.

Las campañas de manipulación de la información en línea pueden ser facilitadas y exacerbadas por prácticas de moderación del contenido defectuosas y por modelos de ingresos basados en publicidad digital.

Moderación del contenidoLa incontrolada propagación de mis-información y desinformación, discursos de odio y acoso en las plataformas de los medios sociales han colocado los reflectores sobre sus políticas y procedimientos de moderación de contenidos, que a menudo se implementan con poca o ninguna supervisión. Las plataformas de los medios sociales han sido criticadas por retirar demasiado contenido, por no retirar suficiente contenido, por preparar algoritmos que no logran detectar los matices de los discursos de odio y la misinformación, y por emplear moderadores humanos que sufren por su baja paga, malas condiciones laborales, y el trauma inducido por el nocivo contenido que revisan. En medio de una cacofonía de voces con opiniones sobre qué contenidos debieran y no debieran permitirse en las plataformas, las compañías de medios sociales luchan por encontrar el equilibrio correcto entre la libre expresión absoluta y la protección de los usuarios de la manipulación de la información. Leyes como la Ley de servicios digitales la Unión Europea da a los legisladores una herramienta con que hacer que las plataformas sean responsables por su papel en facilitar la manipulación de la información, y presenta “una nueva forma de pensar acerca de la moderación de contenidos que es particularmente valiosa para la comunidad contra la desinformación”.

Para mayor información sobre la moderación de contenidos véase el recurso Medios sociales[8].

La publicidad digital ha hecho posible el autofinanciamiento de páginas web y blogs que comparten contenidos detestables, incendiarios y/o engañosos. La publicidad programática, que depende de tecnología automatizada y herramientas algorítmicas para comprar y vender avisos, es especialmente problemática porque los anunciantes podrían terminar financiando estos canales sin ser jamás conscientes de que sus avisos aparecen en ellos.

El movimiento en línea Sleeping Giants surgió para abordar este problema, alertando a las compañías cuando su publicidad aparece junto a contenidos inflamatorios o controversiales. Check My Ads es otro recurso que ofrece servicios para ayudar a prevenir que las marcas queden asociadas con la desinformación o con discursos peligrosos. La Ads for News initiative apoya al periodismo local brindando a las marcas y compradores de medios una lista curada de inclusión global, con páginas web de noticias confiables a las cuales se ha filtrado para excluir las desinformación y otros contenidos no idóneos para las marcas.

Para mayor información sobre la publicidad digital véase el recurso de medios sociales[9].

La manipulación de la información es una práctica común de los regímenes autoritarios, que usan los medios sociales y tradicionales para sembrar el caos y la confusión, así como minar los procesos democráticos. Las entidades gubernamentales en Rusia ya antes se han dedicado a manipular la información en las elecciones en Europa y otros lugares, aprovechando cuentas de bots y granjas de troles para compartir y amplificar la desinformación en los medios sociales, con miras a profundizar las divisiones sociales y políticas ya existentes dentro de los países fijados como objetivo.

La práctica del astroturfing por parte de gobiernos extranjeros, grupos de interés y hasta de anunciantes es una forma común de manipulación de la información. El astroturfing se refiere al uso de múltiples identidades (bots) en línea y falsos grupos de lobby para crear la falsa impresión de un amplio apoyo de base para una política, idea o producto. Esta técnica puede usarse para desviar la atención de los medios o establecer una narrativa particular en torno a un acontecimiento tempranamente en el ciclo noticioso. Otras tácticas de manipulación de la información pueden incluir la manipulación de los buscadores, páginas web falsas, trolling, operaciones de robo y filtración de datos, suplantación de cuentas y censura.

La manipulación de la información no sólo tiene lugar en espacios en línea. Puede propagarse también a través de las fuentes de medios tradicionales (como la televisión, la radio y los canales impresos), así como a través de la academia. Por ejemplo, los medios de comunicación tradicionales podrían inadvertidamente amplificar contenidos creados como parte de una campaña de manipulación de la información, si dichos contenidos fueron compartidos por una figura política importante, si el contenido es particularmente sensacionalista y es probable que atraiga al público, o incluso a través de la cobertura que busca cuestionar el contenido de la campaña de manipulación. Un actor sofisticado que se dedique a manipular la información podría capturar medios noticiosos prominentes u otorgar subvenciones a entidades de investigación para que produzcan análisis que respaldan sus objetivos.

¿De qué modo la manipulación de la información afecta el espacio cívico y la democracia?

La manipulación de la información es tanto un ataque a la confianza como a la verdad. Un entorno informativo cuestionado puede contribuir a disminuir el nivel de confianza pública, a medida que los ciudadanos no pueden o no desean distinguir entre las fuentes de información legítimas y las que no lo son. El vaciamiento de la industria tradicional de los medios y el incremento en el consumo de noticias a través de los medios sociales contribuyen a esta tendencia, en particular en contextos en donde la alfabetización informacional es baja y las instituciones democráticas débiles. Durante las crisis de salud, desastres naturales y otras emergencias, la falta de confianza del público en combinación con la incontrolada misinformación y desinformación podrían estorbar los esfuerzos de respuesta y amenazar la salud y el bienestar de los ciudadanos.

Los gobiernos intolerantes vienen invirtiendo cada vez más en campañas de manipulación de la información focalizadas en la sociedad civil, los defensores de los derechos humanos y los grupos marginados. En Myanmar, por ejemplo, el personal militar estuvo involucrado en una campaña sistemática en Facebook para difundir propaganda y comentarios incendiarios acerca de la minoría rohinyá del país, que es mayormente musulmana, lo que finalmente condujo a una difundida violencia offline y a la más grande migración humana forzada de la historia reciente. El acoso y trolling de periodistas y candidatos políticos (sobre todo mujeres) en las plataformas digitales podría provocar la autocensura o su alejamiento definitivo de los espacios en línea, lo que tiene un efecto negativo sobre la diversidad de voces en la esfera informativa.

De otro lado, los gobiernos desde Singapur hasta Kenia o Camboya también han implementado y usado leyes de “fake news” para restringir la libre expresión y amordazar el disenso en nombre de combatir la manipulación de la información. Durante la pandemia de COVID-19, un periodista egipcio que criticó la respuesta dada por el gobierno fue acusado de estar propagando noticias falsas, mal uso de los medios sociales y de haberse unido a un grupo terrorista, demostrando así que el uso demasiado entusiasta de tales leyes podría facilitar la censura. Estas leyes contra las “fake news” pueden a veces extenderse más allá de las fronteras nacionales, como sucediera en el caso de la ONG malasia cuya página web fuera bloqueada en Singapur después de que publicara un artículo acerca de los prisioneros del país condenados a muerte. Las disposiciones legales que permiten restringir contenidos pueden ser incluidas en diversas leyes acerca del cibercrimen, la difamación, la tecnología de la información, la sedición, los medios sociales etc.

Al igual que en el caso de la guerra entre Rusia y Ucrania (a la cual algunos han denominado la primera “guerra de los medios sociales” real), los conflictos ahora se libran no sólo en los campos de batalla sino también en los medios sociales y otros espacios en línea. La campaña informativa que Rusia desplegó en contra de Ucrania incluyó el uso de propaganda, cuentas falsas en los medios sociales y videos manipulados para sembrar divisiones, generar confusión y en general erosionar el respaldo internacional a Ucrania. Estos esfuerzos tuvieron más éxito en persuadir a la opinión pública en algunos países que en otros, pero en general guardan lecciones importantes acerca del papel de la desinformación para futuros conflictos internacionales.

Manipulación de la información y elecciones

El uso estratégico de información falsa, exagerada o contradictoria durante las elecciones es una poderosa herramienta con la que socavar los principios democráticos. La frontera deliberadamente desdibujada entre la verdad y la ficción amplifica la confusión de los votantes y devalúa el debate político basado en hechos. Los rumores, habladurías y acoso en línea se utilizan para dañar reputaciones políticas, exacerbar las divisiones sociales, movilizar partidarios, marginar mujeres y grupos minoritarios, y minar el impacto de los agentes de cambio.

Los contenidos que buscan desalentar o impedir que los ciudadanos voten pueden tomar el aspecto de información imprecisa acerca de la fecha de una elección, o de intentos de persuadir a la gente de que una elección está arreglada y de que su voto no importa. Los contenidos de supresión de votantes que cuestionan la legitimidad de los procesos electorales o la seguridad de los sistemas de votación, pueden también sentar las bases para cuestionar los resultados electorales puesto que la manipulación de la información degrada la confianza en los cuerpos que manejan las elecciones. Estos contenidos no necesitan de intención maliciosa alguna pues por ejemplo, alguien que comparte inadvertidamente información incorrecta acerca de la fecha límite para la inscripción de los votantes, podría también confundir a otros ciudadanos e impedir que sean capaces de votar en la elección.

Distintos actores tienen distintos objetivos para influir las narrativas en el transcurso de una elección. Por ejemplo, los partidos y campañas políticos pueden usar la mis-información, desinformación, mal-información o propaganda para desacreditar a la oposición o manipular el discurso político de tal modo que sirva a su agenda de campaña, en tanto que un adversario extranjero podría buscar influir en el resultado electoral, promover intereses nacionales o sembrar el caos. Una campaña coordinada de manipulación de la información en WhatsApp —que incluyó fotografías alteradas, clips de audio manipulados y falsas “verificaciones de hechos” que desacreditaban a noticias auténticas— tuvo un papel preocupante en impulsar al candidato de extrema derecha Jair Bolsonaro a la presidencia del Brasil en 2018 (para mayor información acerca del papel de la manipulación de la información en el Brasil véase la sección de estudios de caso).

En última instancia, las campañas de manipulación de la información pueden desestabilizar entornos políticos, exacerbar la posible violencia relacionada con las elecciones, pervertir la voluntad de los votantes, afianzar a los autoritarios y minar la confianza más en general en los sistemas democráticos. En muchas democracias frágiles, las instituciones democráticas vigorosas que podrían ayudar a contrarrestar el impacto de las noticias falsas y las campañas más amplias de manipulación de la información, como unos medios fuertes e independientes, partidos políticos ágiles y sofisticadas organizaciones de la sociedad civil, siguen en estado emergente.

¿Qué puede hacerse para enfrentar la manipulación de la información?

Una herramienta que los periodistas, investigadores y la sociedad civil pueden usar para contrarrestar la manipulación de la información es la verificación de los hechos, esto es el proceso de comprobar la información y brindar análisis precisos y no sesgados de una afirmación. En los últimos años han surgido cientos de iniciativas de verificación de los hechos en la sociedad civil en torno a puntos críticos específicos, siendo las lecciones aprendidas así como la infraestructura construida en torno a dichos puntos críticos aplicada luego a otros problemas que impactan estos mismos ecosistemas informativos. Durante las elecciones generales mexicanas de 2018, la iniciativa Verificado 2018 de la sociedad civil se asoció con Pop-Up News, Animal Político, AJ+ Español y 80 otros socios para verificar los hechos y distribuir información relacionada con las elecciones, especialmente entre los jóvenes. Otras iniciativas exitosas de verificación de hechos en todo el mundo son Africa Check, el Cyber News Verification Lab de Hong Kong, BOOM en la India, Checazap en Brasil, la Fact Check archive del Centre for Democracy and Development en África occidental, y la iniciativa Check de Meedan en Ucrania.

Las compañías de medios sociales también han invertido en equipos y tecnologías de verificación de hechos, y han construido sociedades con agencias noticiosas para responder a los bulos, teorías de la conspiración, rumores y propaganda que circulan en sus plataformas.

La verificación de los hechos o “debunks” (desmentidos) son eficaces, pero tienden a tener un uso intensivo de trabajo y no son leídas por todos. El “prebunking” (desmentido preventivo) es un enfoque alternativo basado en la idea de vacunar a la gente en contra de información falsa o engañosa mostrándole ejemplos de manipulación de la información, de modo tal que en el futuro estarán mejor equipados para identificarlas y cuestionarlas. Según First Draft hay tres tipos principales de prebunks:

-

Basados en hechos: corrigen una afirmación o narrativa específica falsa

-

Basados en la lógica: explican las tácticas de manipulación usadas

-

Basados en fuentes: señalan las fuentes de información malas

En 2022, Google lanzó una campaña de prebunking en Polonia, la República Checa y Eslovaquia para diseccionar distintas afirmaciones falsas acerca de los refugiados ucranianos. Los investigadores también han creado juegos en línea que permiten a los jugadores simular ser trols que propagan fake news, con miras a mejorar la comprensión que la gente tiene de cómo se construyen las campañas de manipulación de la información, incrementando finalmente su escepticismo para con ellas.

Los programas de educación mediática pueden ayudar a incrementar la capacidad de los ciudadanos para distinguir contenidos factuales y falsos o engañosos, alentando su uso de habilidades de pensamiento crítico, al mismo tiempo que consumen contenidos de medios tradicionales y en línea. Estos programas pueden también elevar la conciencia de que la manipulación de la información daña de modo desproporcionado a las mujeres y grupos marginados. La educación mediática es un proceso que dura toda la vida, y debiera no ser sino una parte de un equipo de herramientas completo para responder a la manipulación de la información.

La iniciativa Learn to Discern (L2D) de IREX busca construir la resiliencia de las comunidades a la desinformación, la propaganda y los discursos del odio en los medios tradicionales y en línea. Luego de pilotear un currículo de educación mediática en salones de clase, bibliotecas y centros comunitarios en Ucrania, L2D fue extendida a otros países, entre ellos Serbia, Túnez, Jordania e Indonesia. Las iniciativas globales como el marco Web Literacy de la Fundación Mozilla, y la biblioteca de educación digital de Meta, brindan acceso a materiales de educación mediática, y ofrecen una oportunidad para que los usuarios aprendan cómo navegar de modo eficaz el mundo virtual.

Las plataformas pueden aprovechar las características de diseño para ayudar a mitigar la manipulación de la información. Por ejemplo, algunas plataformas envían estratégicamente artículos con información correctiva a los usuarios que comparten contenidos falsos. Durante la pandemia de COVID-19, Facebook mostraba mensajes a los usuarios que interactuaban con contenidos falsos, y también los redirigía a fuentes autorizadas como la Organización Mundial de la Salud (OMS) o los Centros para el Control y Prevención de las Enfermedades (CDC). Estas intervenciones, conjuntamente con las políticas y elementos diseñados para limitar la remisión de contenidos virales, buscan aminorar el impacto de la manipulación de la información.

La inteligencia de fuentes abiertas es un método de recolección de datos e información de fuentes públicamente disponibles, entre ellas medios sociales, páginas web y artículos de noticias. La recolección y el análisis de información transparente, liderada por voluntarios y colectiva (crowdsourced) puede contribuir al desmentido de falsedades y mitos, lo que incluye a contextos como la guerra ruso-ucraniana. El grupo de periodismo investigativo Bellingcat se ha establecido como un líder en el uso de OSINT para reportar acerca de conflictos y abusos de derechos humanos, como el uso de armas químicas en la guerra civil de Siria.

El contradiscurso por lo general incluye toda respuesta directa al lenguaje de odio o dañino y busca socavarlo. Según el Dangerous Speech Project, hay dos tipos de contradiscurso: campañas organizadas de contra-mensajes y respuestas orgánicas espontáneas. El contradiscurso puede a veces buscar educar al perpetrador del contenido nocivo, pero usualmente busca más bien reconfigurar la discusión en línea para los espectadores, cambiar el tono en los espacios públicos en línea, y desplazar los contenidos nocivos con mensajes positivos e inclusivos. Un ejemplo del contradiscurso en acción es #jagärhär (#Iamhere), un grupo de Facebook de unas 75,000 personas con sede fundamentalmente en Suecia, que se ha movilizado para agregar notas positivas en las secciones de comentarios en donde estaban propagándose el odio y la misinformación.

¿Qué puede hacer la sociedad civil para limitar la manipulación de la información?

La información confiable y auténtica es crucial para una gobernanza transparente, inclusiva y que rinda cuentas, y para la capacidad de la ciudadanía para ejercer sus derechos y responsabilidades cívicos. La sociedad civil, en particular, tiene un importante papel que desempeñar en limitar los efectos de la manipulación de la información y en fortalecer la resiliencia de los ecosistemas de información locales.

-

En primer lugar, la sociedad civil puede actuar como ‘watchdog’. Al monitorear de cerca los medios sociales, la sociedad civil puede identificar y exponer las campañas de manipulación de la información que afectan a sus comunidades locales a medida que van apareciendo. Para este trabajo es crucial el acceso continuo de investigadores tanto académicos como no académicos a los datos de los medios sociales.

-

En segundo lugar, la sociedad civil está singularmente ubicada para implementar iniciativas educativas y de extensión, entre ellos los programas de educación mediática, que empoderan a las personas para que reconozcan la manipulación de la información. Esto podría involucrar la coordinación con colegios, bibliotecas, centros comunitarios y otras partes interesadas.

-

Tercero, la sociedad civil puede aplicar presión a las compañías tecnológicas, empresas y anunciantes que alojan, apoyan o incentivan, voluntaria o involuntariamente, a los creadores de contenidos falsos o engañosos.

-

Cuarto, la sociedad civil puede trabajar con los gobiernos para reemplazar las “leyes anti fake news” y otras amplias restricciones de contenidos, con leyes menos restrictivas que combatan la desinformación al mismo tiempo que protegen la libertad de expresión.

Preguntas

Hágase las siguientes preguntas si está intentando entender cómo mitigar los riesgos de la manipulación de información en su trabajo:

-

¿Cómo es que mi organización verifica la información? ¿Qué controles internos tiene para prevenir la propagación inadvertida de contenidos falsos o engañosos?

-

¿Qué capacitaciones o programas internos debiéramos efectuar para entender mejor los riesgos asociados con la manipulación de información?

-

¿Cómo podríamos responder a una campaña de manipulación de la información focalizada en su organización o sus asociados?

-

¿Qué estrategias de distribución de contenidos —más allá de las publicaciones— podría considerar para prevenir y responder a la manipulación de la información?

-

Cuando publicamos algo errado, ¿cuál es nuestro proceso para hacer correcciones?

-

¿Qué protocolos de seguridad debieran existir en caso un miembro del personal, participante o asociado sea blanco de desinformación, violencia en línea, acoso, doxxing, etc.?

-

¿Qué programas o iniciativas podemos crear e implementar para mejorar la educación mediática en nuestra comunidad?

Estudios de caso

Operaciones de información rusas en UcraniaReality Built on Lies: 100 Days of Russia’s War of Aggression in Ukraine

(La realidad construida sobre mentiras: 100 días de la guerra de agresión rusa en Ucrania)

“Tal vez la característica más significativa de la campaña de desinformación y manipulación de la información del Kremlin, que tiene como objetivo a Ucrania en la guerra de agresión rusa, es su adaptabilidad a nuevas realidades. En otras palabras, a lo largo de los últimos cien días, el Kremlin ha ido desplazando constantemente las metas de su desinformación, en un intento de redefinir cuáles son los objetivos de la ‘operación especial’ y qué podría ser un ‘éxito’ para las fuerzas armadas rusas que han invadido Ucrania… Además de ir desplazando las metas del éxito, los canales de desinformación controlados por el Estado ruso también postulan activamente unas falsas narrativas ‘humanitarias’ con otra finalidad. A medida que el mundo inevitablemente se enteraba de las insensatas atrocidades que Rusia cometía en Ucrania, que cada vez más venían a ser crímenes de guerra, el ecosistema de desinformación pro-Kremlin trabajaba a toda máquina para negar, confundir, distraer, consternar y echarle la culpa a otros”.

La iniciativa global #ShePersisted entrevistó a más de cien dirigentes y activistas políticas mujeres de todo el mundo, en un intento de comprender los patrones, el impacto y el modus operandi de las campañas de desinformación de género contra las mujeres en la política. Los estudios de caso sobre Brasil, Hungría, India, Italia y Túnez exploran cómo la desinformación con género ha sido usada por los movimientos políticos, y a veces por el mismo gobierno, para socavar la participación política de las mujeres, así como para debilitar las instituciones democráticas y los derechos humanos. La investigación crucialmente también examinó las responsabilidades y respuestas que tanto los actores estatales como las plataformas digitales tomaron para abordar este problema, o, más a menudo, que no tomaron.

Disinfodemic: Deciphering COVID-19 Disinformation(Desinfodemia: descifrando la desinformación del COVID-19)

“Al contaminar la comprensión pública de distintos aspectos de la pandemia y sus efectos, la desinformación en torno al COVID-19 aprovechó una amplia gama de formatos. Muchos fueron perfeccionados en el contexto de las campañas antivacunas y de la desinformación política. Frecuentemente meten falsedades de contrabando en la conciencia de la gente al concentrarse en las creencias antes que en la razón, y en los sentimientos en lugar de la deducción. Dependen de los prejuicios, la polarización y la política de identidad, así como de la credulidad, el cinismo y la búsqueda de las personas de una simple explicación ante la gran complejidad y el cambio. La contaminación se propaga en textos, imágenes, videos y sonidos”.

Is China Succeeding at Shaping Global Narratives about COVID-19?(¿Está China teniendo éxito en moldear las narrativas globales acerca del COVID-19?)

“Ante las críticas a su manejo de la pandemia, el gobierno chino y sus agentes aprovecharon los medios sociales, Twitter en particular, para propagar sus narrativas y propaganda en el extranjero… A comienzos de 2021, los medios chinos difundieron afirmaciones según las cuales las vacunas de Pfizer y Moderna eran riesgosas y hasta letales, resaltando las extremadamente raras muertes o enfermedad repentinas de personas que habían recibido la vacuna en Francia, Alemania, México, Noruega y Portugal… Taiwán fue otro blanco importante de las tácticas de desinformación chinas del Covid-19: algo nada sorprendente dado el persistente uso que Beijing hace de la desinformación contra la isla. China buscó repetidas veces poner en duda el éxito de Taipéi en restringir la propagación del virus… Además de criticar y propagar desinformación acerca del manejo que otros países hicieron de la pandemia, los medios de comunicación y diplomáticos chinos amplificaron las teorías conspirativas infundadas de que el SARS-CoV-2 se originó fuera de China”.

Green Latinos, con el respaldo de Friends of the Earth, le encargó a Graphika que estudiara cómo era que las narrativas falsas y engañosas del cambio climático llegaban a las comunidades hispano hablantes. El análisis buscaba entender cómo era que estas narrativas se propagaban a través del ecosistema en línea de los usuarios hispano hablantes de internet, los grupos y personas que las siembran y difunden, y las tácticas que estos actores emplean. Con su análisis, Graphika identificó una extendida red de usuarios en América Latina y España que consistentemente amplifican las narrativas de desinformación climática en español. Aunque algunas de estas cuentas se concentraban específicamente en conversaciones relacionadas con el clima, la mayoría promovía narrativas ideológicamente de derecha, algunas de las cuales tocaban el cambio climático. Muchas de las narrativas identificadas también se superponían con las conversaciones en línea ya existentes que no guardaban relación con el cambio climático, como la misinformación en torno al COVID-19 o las teorías de la conspiración acerca de una organización gobernante secreta de unas elites globales totalitarias.

Fact from Fiction: Curbing Mis/disinformation in African Elections(Separando la realidad de la ficción: conteniendo la mis/desinformación en las elecciones africanas)

“La misinformación y desinformación relacionadas con las elecciones buscan fundamentalmente manipular la toma de decisión de los electorados, sembrar dudas acerca del proceso electoral y deslegitimar el resultado de las elecciones. Esta es una tendencia peligrosa, particularmente en democracias frágiles en donde esto es capaz de incitar el odio y provocar los estallidos de violencia. La misinformación y la desinformación fueron factores importantes en la escalada de la violencia postelectoral en Kenia tras las elecciones generales de 2017. De igual modo en 2020, la República Centroafricana experimentó una letal violencia postelectoral debido a una elección cuestionada, los esfuerzos de desinformación focalizada y un lenguaje divisivo. Lo mismo sucedió en Costa de Marfil, en donde 50 personas fueron muertas en la violencia política e intercomunal que estalló durante la elección presidencial del 31 de octubre de 2020”.

Para un contexto adicional consúltese también el informe The Disinformation Landscape in West African and Beyond, publicado por el Atlantic Council en junio de 2023.

Referencias

A continuación aparecen los trabajos citados en este recurso.

- Bellingcat, (n.d.).

- Bienkov, Adam, (2012). Astroturfing: what is it and why does it matter? The Guardian.

- Bradshaw, Samantha & Philip N. Howard, (2019). The Global Disinformation Order: 2019 Global Inventory of Organised Social Media Manipulation. The Computational Propaganda Project. University of Oxford.

- Carlson, Joe, (2020). Review: ‘Active Measures,’ by Thomas Rid. Star Tribune.

- Chen, Adrian, (2015). The Agency. The New York Times.

- Davis, Seana, (2020). Could a limit on forwarding messages slow coronavirus fake news? Euronews.

- DiResta, Renne, (2016). Social Network Algorithms Are Distorting Reality By Boosting Conspiracy Theories. Fast Company.

- European Parliament, (2019). Deepfakes, shallowfakes and speech synthesis: tackling audiovisual manipulation. European Science-Media Hub.

- Funke, Daniel & Daniela Flamini, (2020). A Guide to anti-misinformation actions around the world. Poynter Institute.

- Hamilton, Isobel Asher, (2020). 77 cell phone towers have been set on fire so far due to a weird coronavirus 5G conspiracy theory. Business Insider.

- Hern, Alex, (2019). Older people more likely to share fake news on Facebook, study finds. The Guardian.

- Human Rights Watch, (2020). Kyrgyzstan: Bills Curbing Basic Freedoms Advance.

- Hussain, Murtaza, (2017). The new information warfare. The Intercept.

- Internews, (2020). Countering COVID-19 Misinformation Via WhatsApp: Evidence from Zimbabwe.

- Internews, (2020). Covid-19 Rumor Bulletins.

- Internews, (2019). Managing Misinformation in a Humanitarian Context.

- Lamb, Kate, (2018). Cambodia ‘fake news’ crackdown prompts fears over press freedom. The Guardian.

- Marwick, Alice & Dana Boyd, (2010). I Tweet Honestly, I Tweet Passionately: Twitter Users, Context Collapse, and the Imagined Audience. New Media & Society, pp. 1-20.

- Newton, Casey, (2019). People older than 65 share the most fake news, a new study finds. The Verge.

- Nimmo, Ben, et al., (2020). IRA in Ghana: Double Deceit.

- Ninmo, Ben, et al. (2020). From Russia With Blogs. Graphika.

- Omilana, Timileyin, (2019). Nigerians raise alarm over controversial Social Media Bill. Al Jazeera.

- Richtel, Matt, (2020). H.O. Fights a Pandemic Besides Coronavirus: An ‘Infodemic’. The New York Times.

- Robins-Early, Nick, (2020). How Coronavirus Created the Perfect Conditions for Conspiracy Theories.

- Rodriguez, Katitza, (2020). 5 Serious Flaws in the New Brazilian “Fake News” Bill that Will Undermine Human Rights. Electronic Frontier Foundation.

- Sample, Ian, (2019). Study blames YouTube for rise in number of Flat Earthers. The Guardian.

- Schalit, Naomi, (2018). WhatsApp skewed Brazilian election, proving social media’s danger to democracy. The Conversation.

- Sen, Ng Jun, (2020). Malaysia-based NGO rejects Pofma order by MHA, says direction in breach of international law. Today Singapore.

- Shengelia, Zaza, (2020). Thin Red Line. Visegrad Insight.

- Staff Reporter, (2018). Kenya signs bill criminalising fake news. Mail & Guardian.

- Stencel, Mark, (2019). Number of fact-checking outlets surges to 188 in more than 60 countries. Poynter Institute.

- Tanakasempipat, Patpicha, (2019). Thailand unveils ‘anti-fake news’ center to police the internet. Reuters.

- The Atlantic, (2019). Ahead of 2020, Beware the Deepfake.

- The Recorded Future Team, (2019). What Is Open Source Intelligence and How Is it Used? Recorded Future.

- Wang, Chenxi, (2019). Deepfakes, Revenge Porn, And the Impact on Women. Forbes.

- Wardle, Claire & Hossein Derakhshan, (2017). Information Disorder: Toward an interdisciplinary framework for research and policy making, Council of Europe.

Recursos adicionales

- Access Now. (2020). Fighting Misinformation And Defending Free Expression During Covid-19: Recommendations For States

- Benesch, Susan, et al. (2020). Dangerous Speech: A Practical Guide, The Dangerous Speech Project.

- Bounegru, Liliana et al. (2017). A Field Guide to “Fake News” and Other Information Disorders. Public Data Lab and First Draft.

- Citron, Danielle Keats. (2017). Addressing Cyber Harassment: An Overview of Hate Crimes in Cyberspace, University of Maryland Francis King Carey School of Law Legal Studies Research Paper No. 2017-9.

- Council of Europe. (2017). Information Disorder: Toward an Interdisciplinary Framework for Research and Policy Making.

- Global Digital Policy Incubator, Social Media Councils From Concept to Reality February 1-2, 2019.

- Interaction, Disinformation: A Unique Danger To Civil Society Organizations

- Jones, Daniel & Susan Benesch. (2019). Combating Hate Speech Through Counterspeech. The Berkman Klein Center for Internet & Society at Harvard University.

- RAND, Tools That Fight Disinformation Online

- Public Data Lab, A Field Guide to “Fake News” and Other Information Disorders

- Riley M, Etter, L and Pradhan, B (2018) A Global Guide To State-Sponsored Trolling, Bloomberg.

- Oxford Internet Institute. (n.d.). The Computational Propaganda Project: Algorithms, Automation and Digital Politics.

- UNESCO, Journalism, ‘Fake News’ and Disinformation: A Handbook for Journalism Education and Training

- USAID, (2020). Digital Strategy 2020-2024.